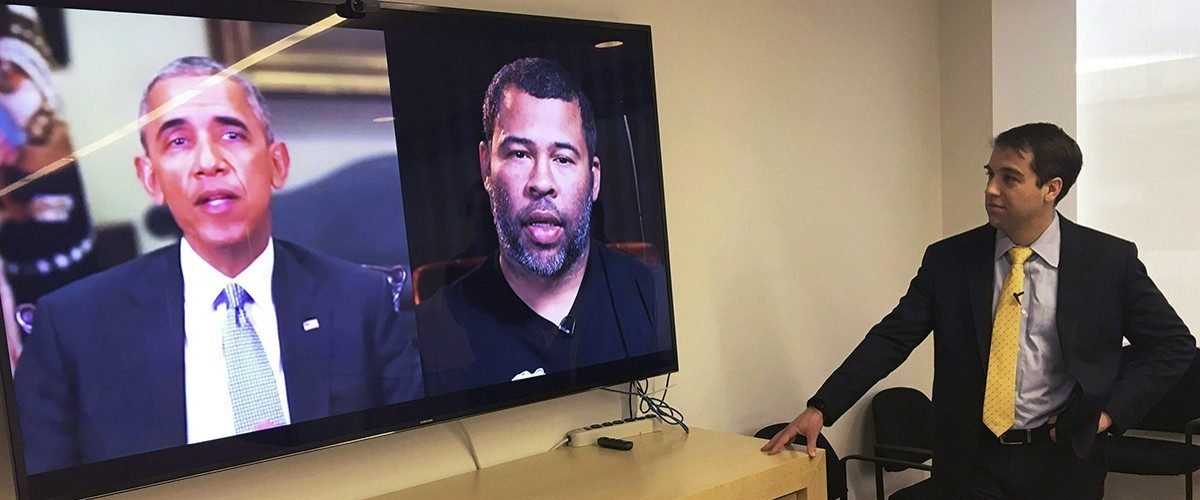

Глубокие фейки (deepfake; дипфейк) – технологии искусственного синтеза человеческого изображения на основе нейросетей и искусственного интеллекта. С помощью технологии одним из первых был создан ролик «Вы не захотите поверить тому, что Обама скажет в этом видео», в котором бывший президент США произносит отдельные провокационные фразы, типа «президент Дональд Трамп – полное дерьмо», и далее показан актёр, произносящий эти слова и демонстрирующий ложность данного видео.

В 2019 году в Интернете получили вирусное распространение поддельные видео с участием глав палаты представителей Конгресса США Нэнси Пелоси (Nancy Patricia D’Alesandro Pelosi), генерального директора Facebook Марка Цукерберга и персонажа сериала «Игра престолов» Джона Сноу (Jon Snow).

Отдельного внимания заслуживает фейковое видео интервью члена палаты представителей Конгресса США Александрии Окасио-Кортез (Alexandria Ocasio-Cortez), в котором она выглядела нелепо и не могла ответить на вопросы. Видео посмотрело более миллиона человек. В комментариях под видео пользователи называли её «полной идиоткой».

Распространению глубоких фейков способствуют:

- большая восприимчивость обывателей к так называемым шоковым новостям по сравнению с обыденными информационными сводками;

- недостаточный уровень осведомленности населения в затрагиваемых вопросах;

- отсутствие возможности фильтровать подобные материалы в поисковых системах на предмет достоверности;

- благоприятствующий позитивному восприятию фейков информационный фон в медиа-мейнстриме.

Глубокие фейки могут использоваться – и в этом состоит угроза – как инструмент межгосударственного информационного противоборства, в террористической, экстремистской и преступной деятельности и для диффамации.

Исследователи выделяют следующие проблемы противодействия применению глубоких фейков:

- у «героев» глубоких фейков (в т.ч. властей и СМИ) отсутствует возможность своевременно опровергнуть недостоверную информацию и прекратить распространение ложного контента;

- люди склонны доверять видеозаписям гораздо больше, чем фотографиям;

- быстрое распространение глубоких фейков через социальные сети (активными распространителями дипфейков становятся люди, чьи взгляды и убеждения соответствуют такому контенту);

- доступность технологий (приложений и онлайн-сервисов) для создания глубоких фейков.

Способами сдерживания процессов изготовления и распространения глубоких фейков эксперты считают:

- использование специальных технических средств и компьютерных криминалистических методик выявления и идентификации дипфейков;

- маркировка контента специальным идентификационным «водяным знаком» до начала его распространения;

- стимулирование платформ социальных медиа к дополнительным усилиям для выявления и удаления глубоких фейков или фальшивого контента;

- ограничение доступа к сетевому изданию или иному информационному ресурсу в Интернете, которые распространяют глубокие фейки;

- ограничение доступа к материалам для обучения изготовителей глубокий фейков (видео- и аудиозаписям людей для моделирования дипфейков);

- введение ограничений на технологии подделки видео с помощью глубоких фейков;

- введение ответственности за создание глубоких фейков (незаконное использование изображений чужого лица);

- создание «сервисов проверенных алиби», которые хранили бы видеозаписи всего, что происходит с человеком – потенциальной жертвой дипфейков и вокруг него (например, вживлённый в кожу человека микрочип или нательный видеорегистратор).

Для противодействия вредоносному применению технологии глубоких фейков органам безопасности, правоохранительным и иным органам уже сейчас необходимо адаптировать инструменты противодействия угрозам с учётом нового технологического вызова.

В конце 2019 года международная антивирусная компания ESET представила отчет о трендах информационной безопасности 2020 года.

В том числе она предупредила, что активно будут развиваться технологии дипфейков, позволяющие при помощи искусственного интеллекта подделывать голоса и лица людей на видео. По мнению экспертов, именно эта технология в 2020 году станет одной из наиболее востребованных среди киберпреступников. В будущем дипфейки могут способствовать еще более широкому распространению фальшивых новостей, поэтому следует скептически относиться даже к самым реалистичным видео- или аудиозаписям.