Роскомнадзор и Главный радиочастотный центр совместно с аналитическим центром Mindsmith и компанией «Ростелеком» в результате исследования «Инструменты ИИ в руках злоумышленников — классификация угроз и способы противодействия» определили 12 ключевых групп технологий на основе искусственного интеллекта (ИИ), которые должны использоваться для выявления опасного онлайн-контента и нейтрализации угроз, обусловленных опасным контентом.

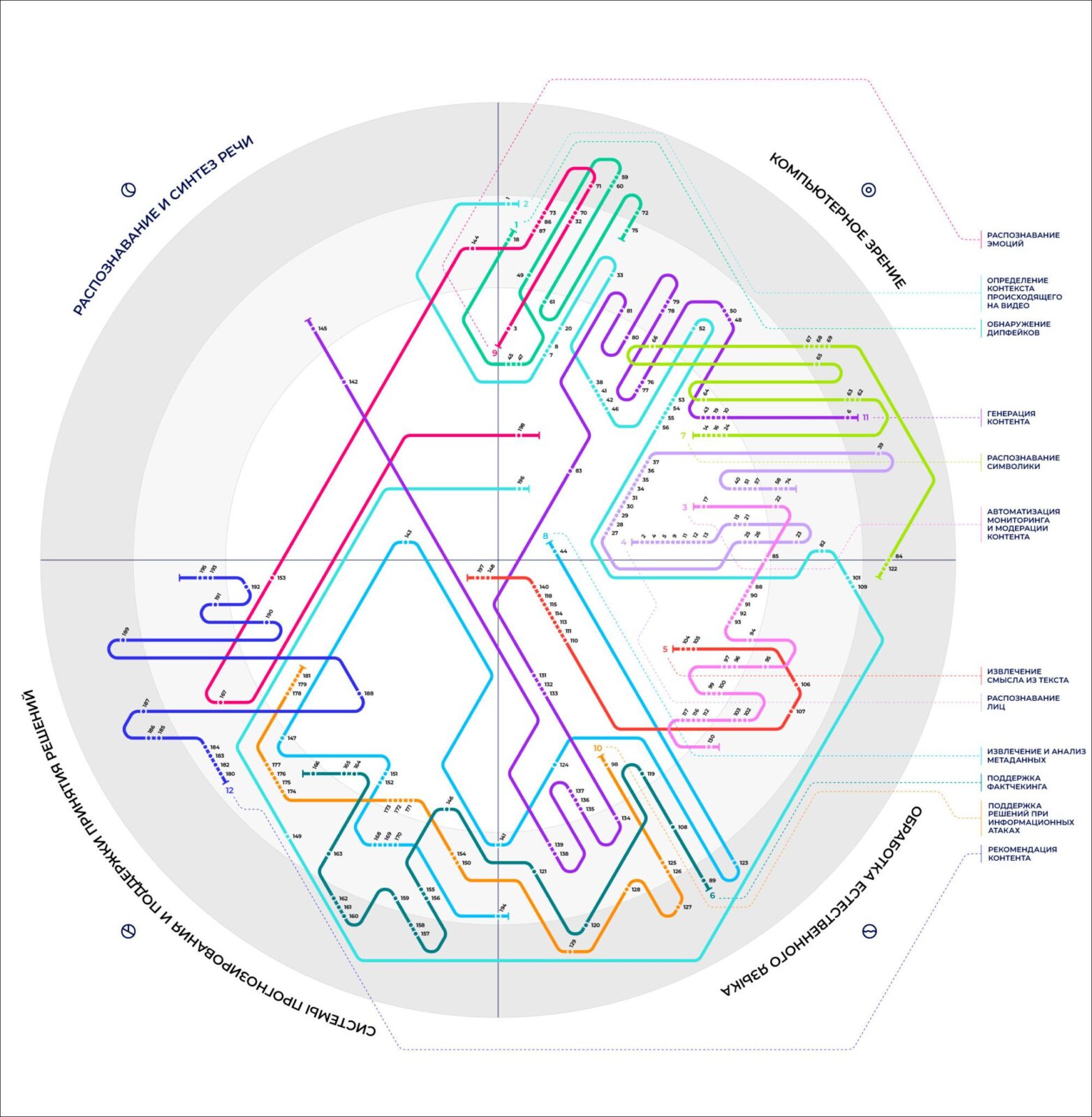

Группы упомянутых технологий:

- Обнаружение дипфейков

- Определение контекста происходящего на видео

- Автоматизация мониторинга и модерации контента

- Распознавание лиц

- Извлечение смысла из текста

- Поддержка фактчекинга

- Распознавание символики

- Извлечение и анализ метаданных

- Распознавание эмоций

- Поддержка решений при информационных атаках

- Генерация контента

- Рекомендация контента

Исследование проводилось на основе анализа научных публикаций, патентов и инвестиционных проектов – всего более трёх тысяч материалов.

Составлена обзорная карта технологий, которая демонстрирует ландшафт разработки решений на основе ИИ в разрезе кластеров, субтехнологий и степени зрелости этих решений.

Круг разделен на четыре сектора и три окружности: секторы показывают субтехнологии, а окружности — степень зрелости технологического решения. Каждое решение представляет собой точку на карте. Местоположение инструмента отображает, к какой субтехнологии он относится и на каком этапе разработки находится. Точки объединены в линии — так показаны функциональные группы инструментов. Это позволяет понять, насколько та или иная группа инструментов готова к внедрению и какие субтехнологии в ней задействованы.

«Из-за автоматизации информационных войн и развития генеративных моделей будет крайне проблематично обеспечить когнитивную безопасность населения без внедрения ИИ. Наличие отечественных моделей и их внедрение, а также использование отечественных наборов данных — вопрос национальной безопасности, так как зарубежные акторы способны экспортировать ИИ, который будет подконтролен только им», – пишут авторы исследования.

Ещё один вывод заключается в том, что государству необходимо решить важную инфраструктурную задачу: разработать процедуры тестирования и оценки моделей ИИ. Это позволит видеть и понимать перспективы развития технологий, отслеживать перспективных разработчиков и перспективные проекты.

Для создания отечественных моделей ИИ в России есть специалисты, но не хватает вычислительных мощностей, инфраструктуры и кооперации между компаниями и государством, отмечают исследователи. Ситуация осложняется тем, что в стране на данный момент недостаточно развито производство мощного вычислительного оборудования. Тем не менее в России есть мирового уровня решения, особенно в области распознавания лиц и работы с информационными атаками.

См. также:

- Российская компания выиграла организованный NIST конкурс разработчиков систем распознавания лиц >>>

- Алгоритмы распознавания лиц VisionLabs признаны лучшими в мире для использования в аэропортах >>>

ИИ-системы безальтернативны для борьбы с глубокими фейками.

Такие системы существуют, они близки к достижению возможности вести фактологическую проверку сообщений в реальном времени. Предполагается их интеграция в соцсети, считают авторы исследования. В будущем возможны анализ речи и потокового видео на предмет обнаружении ложных новостей.

См. также: Запатентованы две технологии Сбера по распознаванию дипфейков >>>

Пока что полностью положиться на ИИ в проверке фактов нельзя, здесь можно автоматизировать только часть процессов. По этой причине многие решения автоматизируют либо одну часть из процесса, либо концентрируются на выдаче оценки конкретному артефакту контента, чтобы в случае выявления подозрительного контента выполнить его дополнительную проверку.

ИИ-системы для фактчекинга находятся на раннем этапе развития и будут массово внедрены только через 3–5 лет, констатируется в исследовании. Внедрение автоматизированной проверки фактов приведет к тому, что каждая новость на крупных платформах будет размечена специальными тегами.

См также:

- Цифровизация с человеческим лицом >>>

- «Яндекс» позвал на работу журналистов, филологов и педагогов для подготовки эталонных текстов для обучения нейросети >>>

- На каких текстах обучается генеративный ИИ Google >>>