Нейронные сети применяются в различных областях: компьютерное зрение, обработка естественного языка (включая перевод с языка на язык), распознавание речи. При распознавании изображений свёрточные нейронные сети (CNN) могут классифицировать различные неизвестные изображения. При обработке естественного языка рекуррентные нейронные сети (RNN) или сети долговременной памяти (LSTM) помогают переводить и обобщать текстовую информацию. При этом сами нейронные сети и необходимое для их использования т.н. «глубокое обучение» имеют ряд принципиальных уязвимостей, которые могут приводить к серьёзным последствиям. Незначительные намеренные изменения в исходных данных или в работе сети порождают неверное распознавание, утечку конфиденциальной информации или замедление работы ИИ-систем. Эти атаки могут принимать различные формы и наносить удары по слабым местам в основных алгоритмах.

В частности, отчёт Белферского центра науки и международных отношений выделяет системы, затрагивающие безопасность граждан, включая безопасность данных, военные системы, правоохранительные системы и информационную безопасность, и отрасли, в которых ИИ заменяет человека. Из-за таких уязвимостей, например, ИИ автономного транспортного средства неправильно распознает дорожные знаки.

Типы уязвимостей

Могут быть выделены следующие типы уязвимостей нейронных сетей и их машинного обучения.

«Извлечение модели» (см., например, отчёт Rochester Institute of Technology) предполагает дублирование модели машинного обучения через API, что не требует знаний обучающих данных и алгоритмов. Основной метод заключается в обучении замещающей модели. Замещающая модель имеет аппроксимированные атрибуты и результаты прогнозов целевой модели. В данном случае целевая модель рассматривается в качестве «чёрного ящика» с неизвестными параметрами.

«Инверсия модели» (подробнее см., например, здесь) предполагает вывод из модели обучающих данных, восстановление принадлежности данных или свойств данных. Так, инверсия модели, используемой в системе распознавания лиц, позволяет с удовлетворительным качеством восстановить изображения, использованные при обучении нейросети.

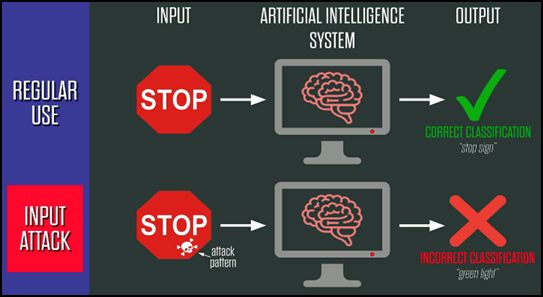

«Отравление» (см. отчёт Белферского центра) – т.е. искажение обучающих данных. Любое манипулирование данными, которое осталось вне поля зрения разработчика ИИ-системы, может иметь катастрофические последствия или поставить под угрозу сам процесс обучения. В известном примере с распознаванием нейросетью дорожного знака обязательной остановки ИИ «принимает во внимание» области красного цвета, форму букв и ряд других характеристик изображения. Зная, как именно обучена нейросеть, злоумышленник может, например, изменить дорожный знак так, чтобы это было незаметно для человека, но ввело бы в заблуждение нейросеть. Существуют иные, весьма разнообразные, возможности «отравить» нейросеть, обеспечив её неработоспособность в определённых условиях.

«Состязание» (подробнее см. здесь) схоже с отравлением, в этом случае также имеет место неверная классификация моделью вредоносной информации, подлежащей обработке нейросетью. Отличие заключается в том, что состязание предполагает использование слабостей самой модели, а отравление ‑ атаку на обучающие данные.

«Уклонение» предполагает внесение «шумов» в обученные нейросети в целях нарушения их корректной работы. Добавляя определённый случайный «шум» в исходные данные (такой «шум», т.е. помехи, вносятся, например, в изображения на уровне пикселей, так, что человеческий глаз их не замечает) за счёт изменения, например, весовых коэффициентов анализируемых признаков, можно сделать так, что нейросеть при определённых условиях утратит работоспособность.

Британская компания Roke Manor Research приводит в своем исследовании шесть уровней злоумышленного проникновения в нейросети для эксплуатации уязвимостей перечисленных типов:

«белый ящик» – позволяет генерировать ложные входные данные, реализуется благодаря инсайдерской информации о нейросети и методах её обучения;

«чёрный ящик» – позволяет настраивать желательную реакцию нейросети на вредоносные входные данные;

замещение нейросети – использование замещающей нейросети в качестве копии подлинной нейросети, это позволяет разработать метод атаки и проверить его на замещающей нейросети;

копирование нейросети – то же, что и замещение, но замещающая нейросеть представляет собой не копию подлинной нейросети, а её имитатор («аппроксимацию»).

Методы реализации угроз

Исследование Roke Manor Research выделяет следующие методы нападения на нейросети:

пиксельные атаки представляют злонамеренное изменение результата классификации изображения нейросетью. Изменение нескольких пикселей или даже одного приводит, например, к неправильной классификации изображения (подробнее см., например, здесь);

проективные и аффинные искажения (подробнее см. здесь) – пространственные искажения, при которых сохраняются линии и параллельность, но не обязательно расстояние и углы;

атаки на оптический поток – изменение передвижения объекта в кадре;

вредоносная заплатка – сгенерированный характерный признак, который накладывается на изображение и приводит к его неправильной классификации изображения, т.е. изменение небольшого фрагмента данных таким образом, что нейросеть обращает внимание именно на него, а не на остальные данные;

триггер – тип атаки, при котором вносятся незначительные изменения в данные, «программирующие» определённую реакцию нейросети, выявление триггеров в обученной модели практически невозможно;

аудиоискажения и имитация речи другого человека – применяются в системах распознавания речи, инструменты синтеза речи на основе нейросетей высокоэффективны для введения в заблуждение современных систем распознавания голоса; синтетическая речь, созданная с использованием общедоступных систем, может обмануть как людей, так и нейросети, аудиоискажения создаются также помехами вне слышимого человеком диапазона частот или повышения уровня шумов в окружении (например, шум работающего двигателя);

энергоатака – заставляет нейронные сети использовать больше вычислительных ресурсов, чем необходимо, чем замедляет процесс «мышления» ИИ-системы.

Выводы

Экспоненциальный рост влияния ИИ на важные отрасли, государственную, экономическую и общественную сферы, требует решения проблем безопасности и доверия к ИИ-системам, комплексных мер и всестороннего анализа исследований в области ИИ.

В качестве таких мер можно, в частности, предложить:

- создание центра мониторинга инцидентов и управления изменениями для ликвидации последствий ошибок, неправомерных действий и целенаправленных атак;

- разработку модели угроз и модели нарушителя для систем, использующих ИИ;

- определение правового статуса интегрированных систем ИИ и анализ полномочий по их практическому использованию;

- создание площадки для обмена лучшими практиками в области обеспечения доверия и безопасности систем, использующих ИИ;

- дальнейшее развитие процессов стандартизации ИИ и научные исследования.

По материалам НТЦ ФГУП «ГРЧЦ»